天文美图都是P出来的

很多人对天文感兴趣,是被一幅幅壮观绚丽的美图带入坑的。可你是否知道,这些美图都是后期做出来的?

【震惊脸,什么什么,退坑】

别走啊,这样做是有道理的,且容我慢慢道来。这里我们不谈艺术家创作的概念图——比如第三视角看到的探测器接近行星,一边转一边拍的银河系全貌,或者群星纷飞的超光速旅行视频——而只说天文望远镜或探测器拍到的照片。

先说最简单直观的:拼图。

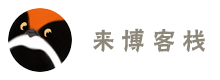

以“旅行者1号”探测器拍的“太阳系全家福”为例,当时是1990年2月,“旅行者1号”已飞到64亿公里以外,它回望太阳系,拍摄制作了这张著名的图片。

图片的主体部分,实际上是由39张单独的照片拼接连缀而成。其中,每个标记字母的地方就是一颗(基本看不见的)行星,如J表示木星(Jupiter)、E表示地球(Earth)、V表示金星(Venus)等等。

为什么不直接来个广角镜头,大家一道喊“茄子”呢?因为每张小照片已经是“广角”镜头拍的了。天文观测的视野通常非常非常小,多亏探测器要拍摄行星全身照,出发时带了个视野稍宽的相机。周边的6张小彩图,才是探测器在同样的位置,用窄视野相机“拉近”拍摄的。

“旅行者1号”拍摄这一系列照片时,需要多次调整镜头指向、设置曝光参数。地面合成时,要忠实地复现这些变化,才能把图片拼接到正确的位置。

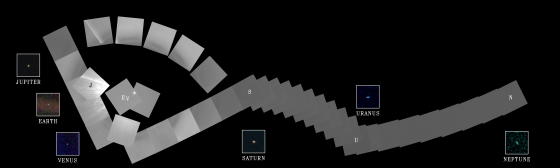

有的拍摄任务并不需要改变太空望远镜的朝向,但因为设计或当时的技术限制,还是要拼图完成。例如“哈勃”望远镜,在1993年到2009年间,它使用第二代广域和行星相机(WFPC2),有4块800×800的CCD感光片。我们看到的最终照片,都是由四幅图片拼接而成的。

这4个CCD中,有1个与众不同,它的视野比其他几块小,但像素一样多。这样,它可以用来拍摄天体的某个局部,供天文学家研究细节。比如,鹰状星云“创世之柱”的照片,本来应该是下图这样:

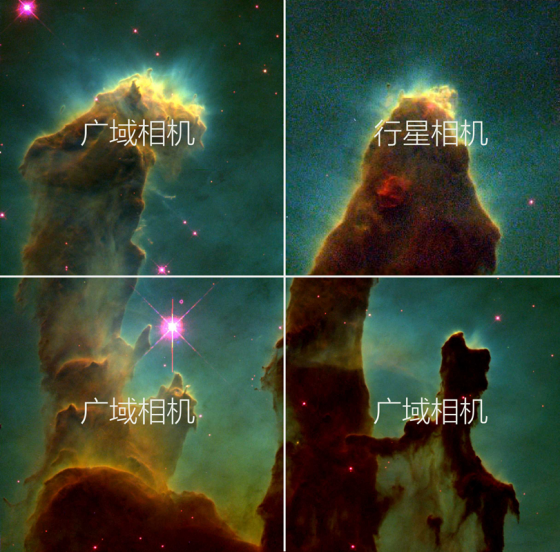

不过,向大众展现时,就得把这个用来放大局部的角缩小,才能和其他三个角拼接成一幅衔接流畅的照片,像下图这样,右侧星云柱上下接合完美:

有得必有失,图片衔接是流畅了,却造成了一个没有内容的缺口。天文学家是有底线的,不会造个虚假背景放在这里。所以,“哈勃”望远镜的许多照片,都有这个标志性的阶梯状暗角,直到2009年,它更新换代,使用了第三代广域相机(WFC3),这个暗角才消失不见。

后发座M100

IC 2944(走鸡星云)

哈勃深空

有时,图片拼接是因为被摄对象条件太极端,无法一下子看全。

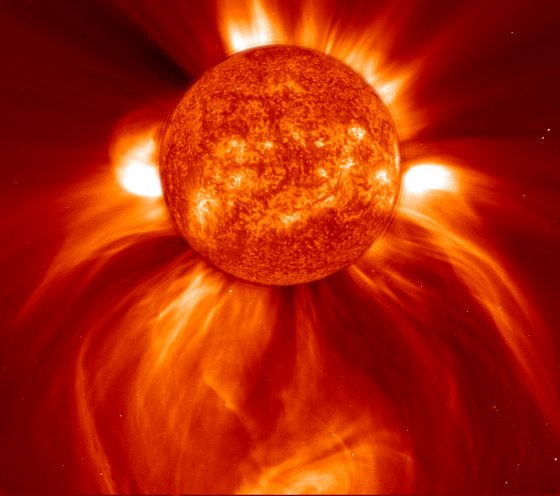

比如下面这幅日冕物质抛射,羽状抛出的物质是由SOHO太阳探测器的LASCO光谱仪拍摄的,但LASCO从来只敢遮着太阳观察日冕——假如它看一眼太阳,那就是最后一眼。中间的太阳,则由探测器上的EIT望远镜在极紫外波段拍到,比正常尺寸放大了些,填到中间,以增强图片效果。这两台仪器,一个不敢看太阳,一个看不到外层日冕,各自拍一部分,拼到一起,就还挺美的。

拼接图片是X-Y方向的操作。有时,我们还需要Z方向的图片加工,也就是叠图。

叠图有三个主要用途:一是增强信号,二是抑制噪点,三则和色彩相关了,我们留到后面的章节细说,先聊聊头两个用途。

下图是我在2015年冬天拍摄的猎户座大星云,谈不上是个好片子,因为是户外随兴拍摄,手边只有一个白天拍鸟的长焦相机,也没有赤道仪用来消除地球自转造成的星光拉丝,只好把相机的感光度调得很高很高,以缩短曝光时间。但相机感光度一高,噪点就噌噌噌地上去了,让人无法分辨一些亮点究竟是真恒星呢,还是卫星或太空垃圾呢,还是相机自己的噪点呢。

请留意图中圈出的4个光点。

我拍了十几幅照片,选了几张质量不错的,仔细地在PS里把它们的亮星对齐,然后,我把上面几个图层设为“变暗”——也就是说,对于每个像素,只显示所有图层中最暗的那个。如果那里有一颗真恒星,它应该在所有图层的同一位置都是亮的,最终会显示出来。如果那只是一颗卫星、一架飞机、一个高感光度造成的噪点,那么它就会被其他图层投票判死。

叠加合成的照片如下,画面干净许多,真星星都留下来了,上图圈出的亮点不见了。我检查了一下,每幅照片里都有它们,在恒星的背景下缓缓移动,可能是卫星吧。

严肃的天文观测中,图像叠加技术要比我的“五分钟PS教程”复杂得多,这里只是简单意会一下。

再以前面提过的哈勃深空为例,这张照片是1995年底拍摄的大熊座内一个极暗的天区。除了前景的几颗银河系恒星之外,可看到的3000多个天体几乎全是遥远的星系,直抵百亿光年以外。如此遥远暗淡的星光,迫使“哈勃”望远镜用了10天时间,环绕地球150周,对着同一天区累计曝光141小时。最终,选取342张照片叠加,去除宇宙射线和地球散射光干扰,增强真正的信号,合成了我们今天看到的哈勃深空图像。

再说说上色。

各种探测器和太空望远镜拍到的照片,其实原图是黑白的,如果要看彩照,就要后期上色。

不不不,不是这种“上色”。在天文照片里,每个像素的颜色都要有根据,可不是影楼里处理老照片那样,抹个红脸蛋,涂个红嘴唇就完事了。

上色的时候,要推敲三个问题:真实吗?科学吗?漂亮吗?三个问题的答案,分别对应一种上色方法,并且有(jīng)时(cháng)会冲突。

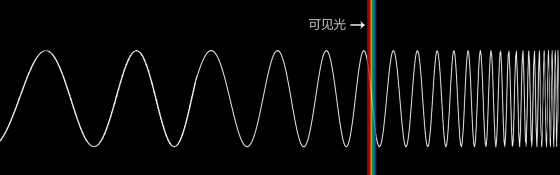

先回到起始问题,为什么照片原图是黑白的呢?并非因为技术落后,能采到的信息贫乏,事实正好相反,是因为信息量太大了。电磁波谱十分宽广,而人眼和大脑能认知的色彩十分有限。超出可见光波段的,一概“伸手不见五指呀”。仪器在可见光以外的波段拍到的图像,该称之为什么颜色呢?

所以,探测器干脆只用明暗来表达它看到的东西,附上波长信息,打个包丢给人类:“喏,这张是微波波段的,这张是红外波段的,这是红光区的,绿光区的,蓝光区的,紫外,X射线,都是黑白片儿,你自己慢慢看吧,只要能分清楚就行。”

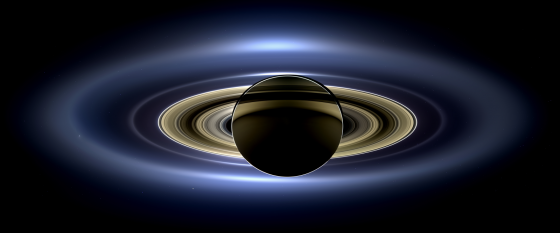

当然啦,如果照片本来就是在可见光波段拍摄的,上色就十分简单。太阳系各大行星和周边卫星的彩照大多如此,只要把蓝绿红三原色各自对应的黑白片挑出来,各自渲染成蓝绿红三色,再一叠加,一张“跟真的一样”的彩照就出来了,和冲洗彩色胶片以及人眼辨色原理一模一样。这种可见光波段的上色,叫做“自然色”。

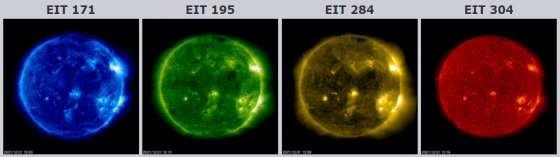

可见光以外,就得用物理+哲学的思路。比如,下面这个太阳极紫外图像四联张,是在17.1nm、19.5nm、28.4nm、30.4nm等波段分别拍摄的太阳。紫外线原本谈不上颜色,但为了快速辨认这些波段,我们不妨按照可见光的波长顺序,从蓝到红为它们赋色。这个色彩顺序符合电磁物理,所以易懂易记,而且,相当美丽!

真实吗?科学吗?漂亮吗?当后两个答案完胜时,就可以拿来挑战第一个问题:我们觉得不真实,纯粹是因为我们眼界太窄,带宽不够……

换句话说,人类不惜代价把那么多仪器送上天,是为了科学研究,而不是观光游览。可见光的狭隘色彩,在整个电磁波谱里,是没有意义的。只要能表达科学信息,就可以抛开天体的可见光色,赋予它完全不同的色彩。这时,我们给照片上的是“代表色”。

还拿“创世之柱”为例,它的原图,本来是3个波段的黑白照片。

其中,左图是氧的502nm蓝绿色辉光,中图是氢和氮的657nm红色辉光,右图是硫的673nm深红色辉光,分别用相应波长的滤镜获得。之所以检测这些波长,是因为这些元素是构成天体的重要成分。

那么问题来了,一个蓝绿色和两个红色叠加配色,结果会是怎样?

结果就是这个样子,它也许更接近天体的真实模样,但这样真实的一片血红,在科学层面上,却没有信息量。

天文学家们追求的,是一目了然。前面说过,为了传递科学信息,我们可以抛弃天体的“本色”。这样,我们把波长最短的氧定义为蓝,把氢+氮定义为绿,把波长最长的硫定义为红(硫:我本来就红……),再做一次图片,忽然就感动得想哭有没有?!

不但图片的色彩更加缤纷绚烂,它也方便传递科学信息。我们知道蓝绿红三原色和各元素的对应关系之后,就能直接解读“创世之柱”各部位的元素分布状况,比“真实”的“血海肉山”要轻松多了。

还有一些上色法,既不真实,也不是为了科学。比如下图的NGC1850,它背后的星云本来发射着氢α线的红光。如果按红色来染,并不妨碍科学表达,但修图师很任性,就是乐意用蓝色来染。这种调进个人审美品味的,叫做“增强色”。

回顾一下,上色三拷问:

真实吗?如果真实,我们把它叫做“自然色”。

科学吗?如果科学,我们把它叫做“代表色”。

漂亮吗?如果漂亮,我们把它叫做“增强色”。

看到这里,想必你对天文美图的制作心中有数了吧!是不是一点都没有退失对宇宙的兴趣,反而更愿意在浩瀚星海中徜徉了呢?